Das Thema Datenschutz getrieben durch DSGVO, die Auswirkung auf die tägliche Arbeit im Marketing und die Chancen und Risiken von Künstlicher Intelligenz in und für das Marketing waren Themas eines Talks mit Lutz Becker und Gunnar Sohn anläßlich der Next Economy Open 2019. Hier die entsprechende Aufnahme auf YouTube:

Wir haben die verschiedenen Aspekte und Facetten andiskutiert: Vom Geheule und Gejammere der Marketingverantwortlichen angesichts der Datenschutzgrundverordnung, die das Ende der Welt, vor allem aber der Zahl von Interessenten, die sie erreichen, lautstark beklagten. Und die jetzt widerlegt zu sei. scheinen, denn weniger Kontakte, die man anschreiben darf, heißt nicht weniger Erfolg

Offensichtlich kann es sogar ganz anders kommen, wie der Marketing Benchmark Report 2019 von Acoustic zeigt. Demnach sind nach Einführung der DSGVO dass die Öffnungs- und Klickraten von E-Mails seit 2014 stetig gestiegen sind (um 19% bzw. 14%). Das deutet darauf hin, dass die Datenschutzbestimmungen die Unternehmen dazu bringen, sich verstärkt auf saubere, den Regularien entsprechende Listenhygiene und gleichzeitig stärker interessiere und engagierte Abonnenten konzentrieren. Und qualitativ bessere Kontakte kombiniert mit einer guten Zielgruppenansprache in Kampagnen erhöht offensichtlich die Erfolgsrate.

Doch nicht nur die DSGVO jagt Marketingfachleuten, Webseitenbetreibern, Werbetreibenden, besonders aber Agenturen, Verlagen, aber auch Facebook oder. Google den Schauer über den Rücken. Das Cookie-Gespenst geht um: Das explizite OptIn, Cookies zu akzeptieren, und Browser wie Firefox oder Safari sind zwei Dinge, die nicht gerne gesehen werden. Da kommt es schon zu knackigen Aussagen wie der von Stefan Mölling von der Axel Springer-Tochter Media Impact:“Die Mozillas dieser Welt bevormunden sowohl die Nutzer als auch die Gesetzgeber“.

Doch es gibt auch die überlegten Aussagen: „Weniger Daten für Marketing und Vertrieb? Weniger Treibstoff für die Digitalbranche?“, unkt Jochen Schlosser. Er plädiert dafür, nicht hysterisch zu werden und stattdessen den Weg weiter zu gehen, digitale Werbung mit der Einwilligung der User zu verknüpfen. Doch die Werbebranche ist natürlich findig und arbeitet an einer Verlagerung des Trackings auf ID Management-Lösungen, wie sie auch die European NetID Foundation treibt: eine Log-in-Allianz mit möglichst vielen Partnerunternehmen als europäische Alternative zu den GAFA(M)s, den Google, Amazon, Facebook, Apple und Microsoft dieser Welt. Über solches ID Management registrieren sich mit ihren persönlicher Daten gleich für vielen Websites – und die geben dort rechtskonform an Nutzer an, ob und in welchem Umfang sie ihre Daten für Werbung zur Verfügung erhalten wollen.

Doch unterdessen kämpfen und lobbyieren Werbetreibenden und Verlage in seltsamer Allianz mit Google und Facebook – sie streiten sich sonst um die Werbeeinnahmen und sind erbitterte Gegener – in Brüssel gegen beziehungsweise für eine Aufweichung der geplanten und immer wieder verzögerten ePrivacy-Verordnung. Einige EU-Staaten scheinen Verlagen einen Blankoscheck für Online-Tracking gewähren zu wollen, andere blockieren genau das und so haben wir in Brüssel ein Pattsituation.

Unabhängig von explizitem OptIn für Cookies oder von ID Managementplattformen, auf denen die Anwender ihren „Consent“, ihre Zustimmung geben, bleibt eine für mich wesentlich Frage offen: Welcher normalen Anwender:innen versteht denn eigentlich die Privacy-Belehrungen, die dort unterbreitet werden? Welche Anwender:innen nehmen sich die Zeit, die entsprechenden Passagen zu lesen? Ehrlich: Ich tue es nicht, weil ich viel zu faul dafür bin und schnell zu den Inhalten kommen will, die mich interessieren. Meine Antwort, dass ich regelmäßig meine Cookies im Browser lösche.

Zurück zu unserem Thema personalisierte Werbung und Datenschutz für die Kunden: Es geht darum ein Gleichgewicht zu finden. so dass Kunden nicht das Gefühl haben, mit Anzeigen verfolgt zu werden die so präzise sind, dass sie eine Verletzung der Privatsphäre darzustellen scheinen. Eine durchaus komplexe und anspruchsvoll Aufgabe, die uns die kommenden Jahre begleiten wird.

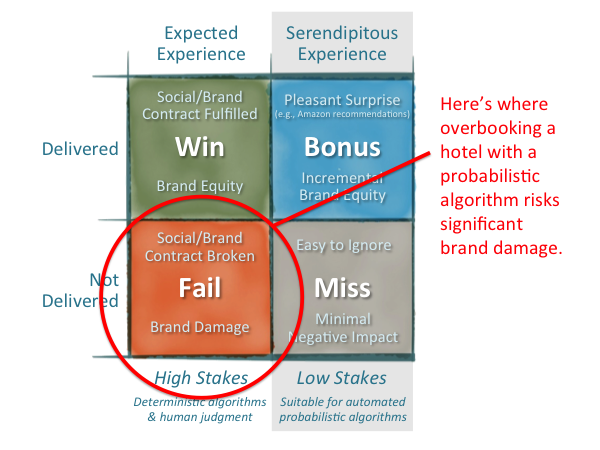

Und in diesem Zusammenhang spielt auch künstliche Intelligenz künftig eine immer wichtiger werdende Rolle. Sie wird im Marketing an den verschiedensten Stellen eingesetzt und man muss sich die entsprechenden Einsatzgebiete sehr genau anschauen. Das reicht von der Erkennung von Mustern, wie sich Kunden auf Webseiten bewegen, über die Bewertung des Umfelds, wo Werbung geschaltet wird, und die automatisierte Ausspielung von Kampagnen (Stichwort Programmatic Advertising), die Vorhersage von Kunden- und Kaufverhalten bis zu Hypertargeting, die Personalisierung auf individueller Ebene. Das reicht eben von der Analyse großer Datenmengen bis zum individuellen Mikrokosmos. Hinzu kommen andere Einsatzgebiete wie Chatbots im Kundenservice oder Vertrieb oder auch der Einsatz im Content Marketing in der Erstellung und Bewertung von Inhalten.

Zum Abschluss dann doch noch einige Anmerkungen zu den mir doch zu plakativen Aussagen über „Datenschutz wie im 18. Jahrhunder“ (so geäußert von Doro Bär und Lutz Becker) oder Daten als Rohöl der digitalen Wirtschaft. Unbenommen ist, dass Daten und der intelligente Auswertung heute ein wichtiges wirtschaftliches (und in manchen Bereichen wie Medizin ein lebenswichtiges) Thema ist. Doch müssen Datenschutz und Nutzung der Daten nicht im Widerspruch stehen. Wie es schief gehen kann, zeigt das aktuelle Beispiel aus den USA, wo Patientendaten einerseits zwecks optimaler Berhandlung und Forschung analysiert werden, andererseits von Google potentiell vermarktet werden.

Daten können und sollten nur dort personalisiert zur Verfügung gestellt werden, wo Anwender explizit auf Basis einer verständlichen Belehrung zugestimmt haben. Daneben kann (und sollte) eine ertragsversprechende Analyse und Verwertung aufgrund anoymisierter Datenbestände eben gerade durch Analytics- und KI-Systeme erfolgen. Unbenommen ist auch, dass wir uns Stillstand nicht leisten können und sollten. Das kann aber andererseits nicht dazu führen, einfach mal den Datenschutz zu vergessen.

Hinweis: Die Themen künstliche Intelligenz, Kampagnenautomatisierung, Personalisierung und Content Marketing sind auch zentrale Themen des Acoustic Launch Events in Stuttgart am 4. Dezember 2019, zu dem ich Interessierte nochmals einlade.

(Stefan Pfeiffer)

Was passiert nun am 4. und 5. Dezember in Stuttgart? Das Acoustic Launch Event beginnt um 15:30 Uhr im Mercedes-Benz Museum. Dort wird Natalie Lamb, designierte EMEA-Chefin für Acoustic, zusammen mit Jay Henderson, Senior Vice President für Produkt Management, die Besucher begrüßen. Jay stellt dann die Produktstrategie von Acoustic vor, das die größte unabhängige Marketing Cloud mit einem offenen, lebendigen Ökosystem werden will. Was gerade die Trends und Themen im digitalen Marketing sind, behandelt dann Martin Meyer-Gossner, der auch als Moderator durch die Veranstaltung führt.

Was passiert nun am 4. und 5. Dezember in Stuttgart? Das Acoustic Launch Event beginnt um 15:30 Uhr im Mercedes-Benz Museum. Dort wird Natalie Lamb, designierte EMEA-Chefin für Acoustic, zusammen mit Jay Henderson, Senior Vice President für Produkt Management, die Besucher begrüßen. Jay stellt dann die Produktstrategie von Acoustic vor, das die größte unabhängige Marketing Cloud mit einem offenen, lebendigen Ökosystem werden will. Was gerade die Trends und Themen im digitalen Marketing sind, behandelt dann Martin Meyer-Gossner, der auch als Moderator durch die Veranstaltung führt. Genau an diesen Stellen gilt es dann auch, das Thema künstliche Intelligenz zu hinterfragen. Was kann KI im Angesicht der DSGVO in der Auswertung der Daten für das Marketing wirklich leisten? Wir haben sicher genug Stoff für eine interessante Diskussion mit den Referenten und dem Publikum. Es haben sich ja schon wortgewaltige Experten mit pointierter Meinung angemeldet. Und wir sind auch noch auf der Suche nach ein oder zwei Sprechern von Unternehmen, die zu den Marketingtrends ihre Meinung haben. Rund um das Mercedes-Benz Museum und in Stuttgart sitzen ja einige namhafte Unternehmen.

Genau an diesen Stellen gilt es dann auch, das Thema künstliche Intelligenz zu hinterfragen. Was kann KI im Angesicht der DSGVO in der Auswertung der Daten für das Marketing wirklich leisten? Wir haben sicher genug Stoff für eine interessante Diskussion mit den Referenten und dem Publikum. Es haben sich ja schon wortgewaltige Experten mit pointierter Meinung angemeldet. Und wir sind auch noch auf der Suche nach ein oder zwei Sprechern von Unternehmen, die zu den Marketingtrends ihre Meinung haben. Rund um das Mercedes-Benz Museum und in Stuttgart sitzen ja einige namhafte Unternehmen. Durch den Tag führen Avril Couper und Mateusz Urban und Kolleginnen aus der Entwicklung werden direkt vor Ort sein, denn in Böblingen sitzen einige der Developer von (bald) Acoustic, die insbesondere an dem Acoustic Content-Produkt arbeiten. Nachdem Jay Henderson an diesem Tag technisch tiefer in die Roadmap eingestiegen ist, wird Thomas Stober aus dem Labor Acoustic Content detailliert unter dem Titel „Content as a Service and Web Sites in a Omnichannel World“ vorstellen- bestimmt ganz besonders interessant, direkt von der Entwicklung mehr über die Pläne zu erfahren.

Durch den Tag führen Avril Couper und Mateusz Urban und Kolleginnen aus der Entwicklung werden direkt vor Ort sein, denn in Böblingen sitzen einige der Developer von (bald) Acoustic, die insbesondere an dem Acoustic Content-Produkt arbeiten. Nachdem Jay Henderson an diesem Tag technisch tiefer in die Roadmap eingestiegen ist, wird Thomas Stober aus dem Labor Acoustic Content detailliert unter dem Titel „Content as a Service and Web Sites in a Omnichannel World“ vorstellen- bestimmt ganz besonders interessant, direkt von der Entwicklung mehr über die Pläne zu erfahren.